Zelfrijdende auto’s raken in de war door stickers op verkeersborden

Amerikaanse onderzoekers hebben ontdekt dat zelfrijdende auto’s gemakkelijk te ‘hacken’ zijn door stickers op verkeersborden te kleven. Wat voor het menselijk oog een subtiele aanpassing lijkt, kan voor zelfrijdende auto’s genoeg zijn om een stopbord te negeren. Met alle gevolgen van dien.

Naarmate auto’s meer en meer online geconnecteerd worden en ook de zelfrijdende wagen zijn opmars maakt, neemt het gevaar toe dat hackers inbreken in de software. Maar een andere mogelijke vorm van hacking wordt meestal over het hoofd gezien: ook de omgeving rondom de auto kan ‘gehackt’ worden. Door kleine aanpassingen op verkeersborden aan te brengen, zou iemand de software van zelfrijdende auto’s flink in de war kunnen brengen.

Artificieel intelligente systemen kijken immers op een andere manier naar de dingen dan wij, mensen. De sensoren van zelfrijdende auto’s werken dan wel ongeveer zoals onze ogen, maar de software die die beelden moet interpreteren werkt op een fundamenteel andere manier dan onze hersenen.

‘Slimme’ software in de maling nemen

Het is al langer bekend dat minieme aanpassingen in beelden ervoor kunnen zorgen dat AI-systemen de beelden op een volledig andere manier gaan interpreteren. Door bijvoorbeeld over de afbeelding van een panda een digitaal laagje te leggen kan je zo’n systeem laten geloven dat het om een gibbon gaat.

Onderzoekers van Google Brain, het AI-onderzoekscentrum van Google, wezen erop dat dergelijke manipulaties ook mogelijk zijn in de echte wereld. Door de gemanipuleerde beelden simpelweg af te printen en te fotograferen met een smartphone, konden ze AI-systemen aan het lijntje houden.

In de AI-community leeft momenteel dan ook een hevig debat over hoe groot het risico is dat zoiets gebeurt met verkeersborden. Kan je ook zelfrijdende auto’s in de maling nemen door die borden een klein beetje te veranderen? Vorige maand verscheen een paper van onderzoekers van de universiteit van Illinois. Hun conclusie leek geruststellend: in het geval van auto’s hoeven we ons daar helemaal geen zorgen over te maken. ‘Omdat de sensoren het verkeersbord vanuit verschillende kijkhoeken en met verschillende groottes zien, zullen ze die fout niet maken’, klonk het.

Bedrogen door een kat

Er kwam echter meteen kritiek op die conclusie door andere experten. Onder meer OpenAI, de non-profitorganisatie van Elon Musk die onderzoek doet naar artificiële intelligentie, trok de claim in twijfel. Op de OpenAI-blog is te zien hoe een ogenschijnlijk onschuldige foto van een kat gemanipuleerd wordt opdat het algoritme gelooft dat er een desktop-computer te zien is in plaats van een kat. Belangrijk daarbij: ze slaagden erin om die manipulatie schaalinvariant te maken. Dat wil zeggen: onafhankelijk van hoe ver of vanuit welke richting de slimme software naar de kat kijkt, ze wordt steeds bedrogen.

Daarmee weerlegden de OpenAI-onderzoekers de claim dat autosensoren ongevoelig zouden zijn voor zulke hacking omdat ze beelden vanuit verschillende hoeken ter beschikking hebben. Althans theoretisch, want er was nog niet aangetoond dat die manipulaties robuust genoeg zijn om ook in de echte wereld zelfrijdende auto’s te verstoren.

Vandalisme op verkeersborden

Daarom hebben Amerikaanse wetenschappers onlangs een nieuw experiment opgezet. Daarin probeerden ze de patroonherkenning van zelfrijdende auto’s te misleiden op drie verschillende manieren.

Eerst bedekten de onderzoekers een stopbord volledig met een afgeprinte versie waarin minieme perturbaties waren aangebracht. Voor mensen is die vervalsing vanop afstand moeilijk te onderscheiden van een écht stopbord, maar zelfrijdende auto’s herkenden er in honderd procent van de testen een bord voor snelheidsbeperking in.

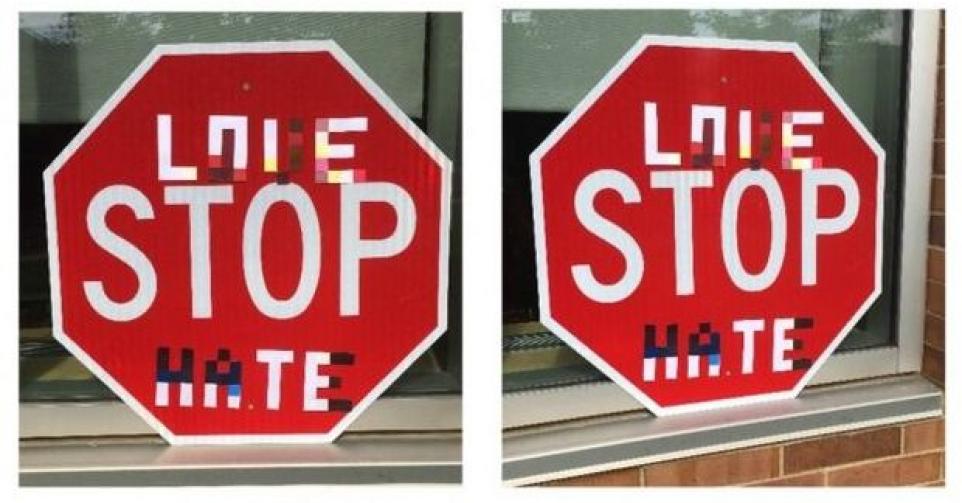

Een tweede methode bestond uit het aanbrengen van ‘vandalisme’ op een stopbord. De onderzoekers kleefden stickers met woorden als ‘love’ en ‘hate’ in graffiti-letters op de verkeersborden. Dat misleidde de software van de zelfrijdende auto’s in twee op de drie gevallen.

Tot slot voerden ze ook een ‘abstracte kunst-aanval’ uit op het verkeersbord: met een aantal strategische geplaatste, smalle stickers slaagden ze erin om alle auto’s op het verkeerd been te zetten.

Hoewel het AI-systeem in ieder experiment meerdere beelden vanuit verschillende afstanden en perspectieven ter beschikking had, werd het keer op keer misleid. Daarvoor hadden de onderzoekers enkel een camera en een kleurenprinter nodig. Iemand met kwade bedoelingen zou het zelfrijdend verkeer dus gemakkelijk in de war kunnen brengen, met alle gevolgen van dien. Voorwaarde is wel dat de hacker al toegang heeft tot het algoritme van de autosoftware zodat hij weet welke aanpassingen hij precies moet aanbrengen.

Een aantal nieuwe automodellen zijn nu al uitgerust met software die verkeersborden kan herkennen, al is nog geen enkel voertuig geprogrammeerd om er effectief op te reageren. De komende jaren zit dergelijke software er zeker aan te komen. Het analoog hacken van de omgeving zal dan een beveiligingsprobleem worden waar producenten maar beter nu al rekening mee kunnen houden.

Fout opgemerkt of meer nieuws? Meld het hier