Een voorstel in het Europese Parlement om robots een rechtspersoonlijkheid te geven, opent de bredere discussie over wat wij van robots verwachten, en hoe ver we daarin willen gaan.

Moeten robots rechten krijgen? Het is een wat vreemde vraag die delen van de Europese Commissie in zijn greep houdt. Om de discussie te volgen, moeten we een jaartje teruggaan, naar januari 2017. Dan brengt een Europese onderzoekscommissie voor Juridische Zaken een rapport uit met aanbevelingen voor veranderingen aan de wetgeving. Bedoeling is om Europa, alvast op juridisch vlak, klaar te stomen voor robotica en artificiële intelligentie. Tussen de aanbevelingen over standaardisering en veiligheidstesten, staat in het rapport ook de suggestie dat robots een ‘rechtspersoonlijkheid’ moeten krijgen.

Wie is er verantwoordelijk?

Zo’n rechtspersoonlijkheid is, voor alle duidelijkheid, nog niet hetzelfde als een Universele Verklaring voor de Rechten van Robots. Ze valt nog het best te vergelijken met de rechtspersoonlijkheid van een bedrijf, zegt Hans Graux, advocaat bij Timelex, een kantoor gespecialiseerd in ICT-recht: “Dat is ongeveer de enige analogie die we hebben.”

Graux werkte de voorbije maanden mee aan een uitgebreide studie voor de Europese Commissie over aansprakelijkheid in robotica en artificiële intelligentie. Als een robot of AI ‘aansprakelijk’ wordt, dan moet het in principe makkelijker worden om er schade op te verhalen. Als u morgen glas vindt in uw potje yoghurt, zo gaat de redenering, dan moet u niet gaan uitvissen waar het exact is fout gegaan: u kan het verantwoordelijke bedrijf aanklagen. Met robots moet dat ook zo gaan. En dat is op zich geen slecht idee, zegt Graux, maar: “De reden dat we niet ondubbelzinnig zeggen dat persoonlijkheid aan robots geven een goed idee is, is simpel. Om iemand aansprakelijk te stellen, moet die persoon geld hebben. Iemand aansprakelijk stellen die geen geld heeft, daar heb je niets aan, want die kan de schade niet vergoeden.”

Als een zelfrijdende wagen een ongeval veroorzaakt, dan is er één bedrijf verantwoordelijk, maar toekomstige robots zullen app-platformen zijn

Bedrijven hebben kapitaal, robots niet. Voor het ooit zo ver kan komen, zouden robots dus eerst moeten beschikken over een fonds waarmee dat geregeld kan worden. En zo ver zijn we nog niet. “Het advies dat we uiteindelijk na het onderzoek gaven,” zegt Graux, “is dat er een aantal aspecten zijn in het aansprakelijksrecht die niet zijn aangepast aan nieuwe technologie. Ons advies was niet dat er specifieke aansprakelijkheidsregels moeten komen, en al helemaal niet dat robots zelf aansprakelijk moesten worden gesteld. Wel is het zinvol om de bestaande regels wat meer te detailleren en strengere regels op te nemen voor producten, zoals software en AI, die in staat zijn om deterministisch te handelen.”

Dat laatste betekent dat die producten ‘zelf kiezen’ op basis van hun programmering. Denk bijvoorbeeld aan Waze, dat beslist welke de beste route van punt A naar punt B is. En aan zelfrijdende wagens, die die route ook volgen. “Het is een idee om een verhoogde aansprakelijkheid te voorzien voor bedrijven die die producten maken, ” gaat Graux verder. “Het gaat dan bijvoorbeeld om de bedrijven die robots bouwen, maar ook om degenen die daar diensten voor uitbouwen. Denk aan zelfrijdende taxidiensten. De Europese Commissie zou hen bijvoorbeeld kunnen dwingen om een specifieke verzekeraar te nemen of om zwarte dozen in te bouwen zodat we weten wat er is gebeurd als het fout loopt.”

Een robot is nooit alleen

Het hele debat klinkt, voor de cynische verstaander, dan ook als een excuus voor de makers van robots om een deel van hun verantwoordelijkheid af te schuiven. Gaan de makders van zelfrijdende wagens in de toekomst geen schadevergoedingen meer moeten betalen als hun auto’s door een etalage rijden? “Dat hangt ervan af hoe je zo’n aansprakelijkheid implementeert”, zegt Hans Graux. “Het risico is er natuurlijk dat je de verantwoordelijkheid afschuift van een bedrijf als Waymo. Maar vaak wordt deze wetgeving gemaakt voor mensen die de huidige situatie te complex vinden. Het is nu te moeilijk voor burgers om beveiligd te zijn. Als er iets fout gaat, is het dan de hardware, de app, of was het jouw fout als gebruiker?” Want robots, zoals elke moderne technologie, zijn een complex gegeven, en ze worden alleen maar ingewikkelder. Dat zegt ook professor Prof. Dr. ir. Bram Vanderborght, die Robotica doceert aan de VUB. “Als een zelfrijdende wagen van Tesla nu een ongeval veroorzaakt, dan is er één bedrijf verantwoordelijk”, geeft hij als voorbeeld. “Maar toekomstige robots zullen app-platformen zijn.” Voor Vandenborght zal de volgende generatie robots niet zo heel anders werken dan de huidige smartphones. “Je gaat bijvoorbeeld een robotstofzuiger hebben, maar waarom bewaakt die je huis niet? Waarom zetten we geen camera op een grasmaaierbot, zodat je kan kijken of alles nog in orde is als je op vakantie bent? Die toestellen kunnen steeds nieuwe functies krijgen.”

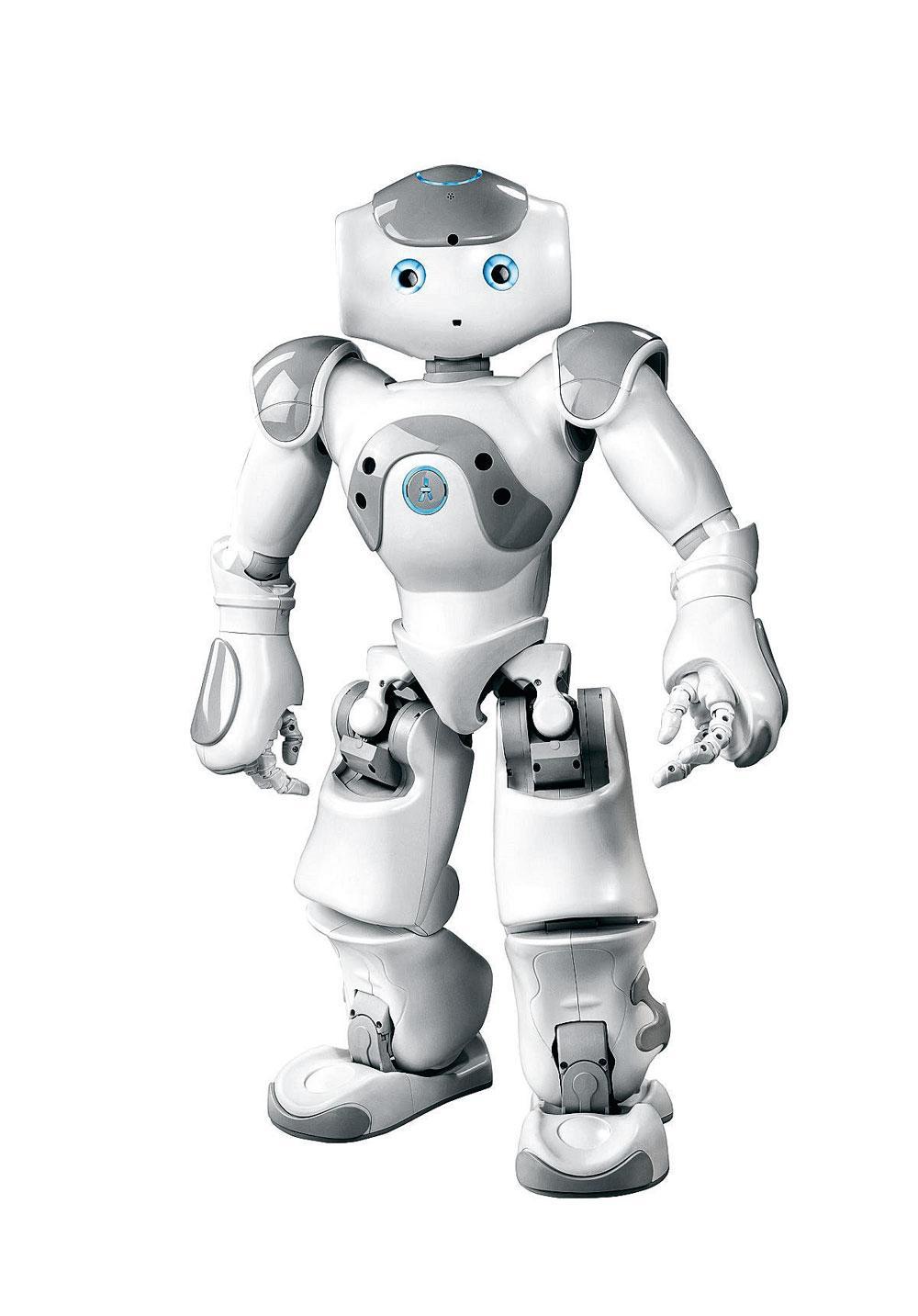

De eerste tekenen van robots als ‘platform’ duiken al op bij de humanoïde toestellen van Softbank Robotics. De bekendste daarvan is waarschijnlijk de receptierobot Pepper. Een kleinere versie, de Nao, is niet alleen populair als voetballende robot, maar kan via gespecialiseerde software andere taken krijgen toebedeeld. Het Franse bedrijf Zora turnt de toestellen bijvoorbeeld om tot ziekenhuisrobot. In die gevallen wordt het al lastiger om uit te vissen wie er verantwoordelijk is als die iets fout doet.

“Nu, een kleine robot als de Nao kan niemand kwetsen, ” zegt Vanderborght, “maar als zo’n toestel meer taken krijgt, moet je al een steviger model hebben. Wat als je een home security app op je humanoïde robot zet, en die verwondt iemand? Wie is er dan verantwoordelijk? Het is een heel jonge sector, en we moeten de balans vinden die mensenrechten vrijwaart, en er ook voor zorgt dat die sector niet versmacht wordt in juridische problemen.”

En dan hebben we het nog niet eens over hoe software er in de realiteit nu al uit ziet. “Veel van de diensten die robots gaan gebruiken, zoals beeldherkenning, gaan in de cloud gebeuren. Dan krijg je de vraag: tot waar gaat die robot?” zegt Vanderborght.

Tot waar gaat de robot?

Nu steeds meer technologie gebouwd wordt met algoritmes en machine learning, wordt de manier waarop software tot stand komt, en de bron waarop een robot zijn beslissingen baseert, bovendien steeds mistiger. Verantwoordelijkheid ligt dan niet alleen bij de ontwikkelaars van de code, maar ook bij de makers van de algoritmes, en de samenstellers van de databank waarop die algoritmes getraind worden. Dat is vooral een probleem wanneer die algoritmes verre van perfect zijn, zegt Katleen Gabriels, assistent-professor Filosofie en Computerethiek aan de Technische Universiteit van Eindhoven.

Om iemand aansprakelijk te stellen, moet die persoon geld hebben

“Natuurlijk zijn daar fantastische applicaties in, ” verduidelijkt Gabriels, “algoritmes zijn even goed als mensen, zo niet beter, in het detecteren van borstkanker of huidkanker, bijvoorbeeld.” Maar soms, zo zegt ze, gaat het mis. Een bijzonder boeiend voorbeeld dat keer op keer opduikt, is dat van de robotrechter.

“In het Verenigd Koninkrijk maakte men een algoritme dat moet nakijken of iemand gerechtelijk mag worden vrijgelaten”, legt Hans Graux uit. De software werd op een databank gezet met enkele duizenden uitspraken, en een van de factoren die het daaruit puurde, en waarop het beslissingen baseerde, bleek het tijdstip van de rechtszaak.”Omdat rechters sneller geneigd zijn om mensen opgesloten te houden naarmate de middag nadert”, zegt Graux. Wanneer menselijke rechters op uiterst menselijke wijze een hongertje krijgen, worden ze strenger, zo blijkt. “Dat is een vooroordeel waarvan geen enkele rechter zich bewust is”, zegt Graux. “Dat is ook geen raciaal issue, geen gender issue. Het is gewoon iets waar mensen niet goed in zijn.”

Het boeiende aan dat voorbeeld is natuurlijk dat die regel in het algoritme expliciet werd gemaakt, en dat hij er, bij de robotrechter althans, ook weer kon worden uitgehaald. “In complexere AI en neurale netwerken wordt dat moeilijker, ” zegt Graux, “omdat men met neurale netwerken zo goed mogelijk menselijke hersenen nabouwt. Zo kan je niet makkelijk meer zien waarom een beslissing werd genomen.”

Technologie is niet neutraal

Een algoritme zoekt patronen in een set gegevens, zonder daar bijzonder over na te denken. En dan hangt alles af van de keuze aan gegevens. “Het is belangrijk om weten dat die technologie niet neutraal is, ” zegt Gabriels. “Ze wordt getraind op datasets die niet neutraal zijn, vaak omwille van ontbrekende of vooringenomen data.”

Voorbeelden zijn er genoeg van AI die wat vooringenomen is, en het zijn vaak de meest gevoelige scenario’s die de internationale pers halen. Denk aan beeldherkenning die mensen met een donkere huid ofwel niet herkent, ofwel als apen wegzet. Pijnlijk, maar meestal ook redelijk onbewust gegroeid op basis van een databank, net als bij de robotrechter. “Eigenlijk sluipen onze menselijke vooroordelen daarin,” aldus Gabriels. “Als je met een vooringenomen dataset traint, ga je dat niet verhelpen. Uiteraard is het de bedoeling dat algoritmes het beter of objectiever doen dan mensen, maar vaak doen ze dat nog niet.”

Om die zaken te verbeteren, moeten ingenieurs zich meer bewust worden van deze problemen, zegt Gabriels, liefst al van bij de ingenieursopleiding: “Het moet worden opgelegd dat ze daarnaar moeten kijken, want die mensen hebben wel een hele verantwoordelijkheid.”

Ook Graux geeft aan dat de wereld gevoeliger begint te worden voor de ethische implicaties van datakeuzes. Hij geeft alvast één voorbeeld. “De Europese commissie subsidieert massa’s onderzoek, ” zegt Graux, “en een van de verplichtingen in de laatste twee jaar is een ethische effectenbeoordeling.” Wie subsidies wilt ontvangen, moet kijken of het project eventueel discriminerende gevolgen heeft. “Dat gaat niet alles oplossen, ook omdat er soms verrassingen zitten in de data. Maar het dwingt wel om daarover na te denken”, aldus Graux. “AI kan een grote dienst bewijzen, net door beslissingen te nemen, maar ook door te dubbelchecken. Mensen zijn terecht nerveus over discriminatie, maar vergeten dikwijls dat mensen zelf ook heel imperfect zijn.”

Domme robots en slimme robots

Begin april sturen 156 AI-experts in veertien Europese landen een open brief naar de Europese Commissie, waarin ze hun weerstand kenbaar maken tegen een rechtspersoonlijkheid voor robots. Bij de ondertekenaars zitten onder meer computerwetenschappers en professoren, waaronder enkele van de UCL. Hun belangrijkste standpunt is dat een rechtspersoonlijkheid voor robots ongepast is, niet alleen vanuit een legaal perspectief, maar ook vanuit een ethisch perspectief. Het idee daarachter is dat zo’n persoonlijkheid alleen van toepassing is op ‘deterministische’ robots, die eigen beslissingen maken. En daar zijn we nog lang niet, legt Graux uit. “Het probleem is dat we op dit moment al veel spectaculaire scenario’s in het hoofd hebben, maar dat AI zelf nog in een erg triviale fase zit. Het is gevaarlijk om wetten te beginnen schrijven op basis van fantasieregels. AI is nog niet zo gesofisticeerd dat we niet kunnen voorspellen wat die robot gaat doen.”

Het debat over rechtspersoonlijkheden komt ook voor Gabriels te vroeg. “Veel van onze ideeën zijn gevoed uit science-fiction,” zegt ze. “Je moet bij AI heel goed het onderscheid maken tussen sterke en zwakke AI. Als mensen bang zijn voor een zelfbewuste artificiële intelligentie, of voor robots die de wereld overnemen, dan gaat dat over sterke AI. En dat bestaat nog helemaal niet. Wat we nu al hebben is heel beperkt. Denk aan Google Translate, of zelfrijdende wagens, of beeldherkenning. Dat is zwakke AI.”

Die zwakke AI is ook wat uw robotstofzuiger aanstuurt wanneer die met het enthousiasme van een rubberen bal tegen de muren en meubels van de woonkamer botst. “Gaan robots de wereld overnemen?” vraagt professor Vanderborght aan het begin van zijn presentatie op het AND& festival. Achter hem speelt een montage van enkele minuten, waarin robots steeds opnieuw omvallen, of zich mispakken, of hoe dan ook de mist in gaan. “Ze zullen overal zijn, ” gaat Vanderborght verder, “maar we zijn nog niet zo ver dat een robot zal werken als je hem in een omgeving zet waaraan hij niet gewend is.”

Het trolleyprobleem

Geen zelfbewuste Terminators, dus. De militaire drones die al jaren in plaatsen als Afghanistan worden ingezet om militaire doelwitten neer te halen, hebben vaak nog een mens achter het stuur.

Puur softwarematige doden vallen er vooral elders. Elaine Herzberg wordt zo in maart van dit jaar in de Amerikaanse staat Arizona van haar fiets gereden. De vrouw overleeft de klap niet. De verantwoordelijke: een zelfrijdende Uber. Uit onderzoek achteraf blijkt dat de wagen de vrouw wel had gezien – zelfrijdende auto’s zijn uitgerust met meer sensoren en camera’s en zintuigen dan een mens ooit zal hebben – maar dat er ergens in de software werd ‘besloten’ om haar te negeren. Iets wat, zo hopen we, in een volgende versie wordt verholpen. “De algoritmes van zelfrijdende wagens zijn nog volop aan het leren, ” zegt Katleen Gabriels. “Die gaan fouten maken. Maar als er meer ongelukken gebeuren, gaan die meer leren. Dat is wrang en niet bepaald ethisch.”

Het is gevaarlijk om wetten te beginnen schrijven op basis van fantasieregels

Het zijn dit soort scenario’s die op dit moment het meeste angst inboezemen. In het geval van Uber gaat het waarschijnlijk over een bug, maar in andere (bijzonder zeldzame) scenario’s moet er effectief een keuze worden gemaakt tussen, pakweg, een kind doodrijden of de vier inzittenden in gevaar brengen. Het zogeheten ‘trolleyprobleem’. Dat zijn ethische keuzes die menselijke chauffeurs in een splitseconde moeten maken, maar die bij robots uit de code moeten komen.

Het belangrijkste daarbij, zegt Hans Graux, is dat ze effectief op voorhand worden gecodeerd. “Mensen die dat soort producten ontwikkelen, moeten een ‘impact assessment’ maken, een beoordeling waarin ze zelf specificeren wat de gevaren van het product zijn. En wat ze daaraan doen.” Dat lost het trolleyprobleem niet op, geeft ook hij toe, maar stap één is alvast dat erover wordt nagedacht. Een belangrijk punt daarbij, zegt Graux, is dat we ook naar de big picture moeten kijken. “België is een land met bijzonder veel doden in het verkeer. Achthonderd mensen per jaar. Stel dat we met automatische wagens naar tweehonderd doden gaan. Als jouw ouder, of je kind, bij een van die tweehonderd zit, dan vind je dat schandalig. Zeker als die robot de keuze maakt om jouw kind te doden. Maar voor de maatschappij kan dat een goed resultaat zijn. Mensen hebben de neiging om zich vast te pinnen op individuele rampscenario’s, maar vergeten dat de maatschappij daar misschien wel bij vaart. Waarom heeft een robot die beslissing genomen, en staan we daar als maatschappij achter? Willen we dat het anders gaat? Als een mens iemand doodrijdt is het meestal een paniekreactie. Bij robots kunnen we daar meer over nadenken, dat is wel een voordeel.”

Ook Gabriels vindt dat de ethische vraag geen achterafje mag worden. “Je moet die in de technologie inprogrammeren. Aan de Universiteit van Eindhoven krijgen alle studenten verplicht ingenieursethiek. Dat gaat om value sensitive design, om ethische waarden beschermen in plaats van verder onder druk zetten.” Ze geeft het voorbeeld van GDPR, dat hetzelfde beoogt met privacy by design. “Als je dat kan opnemen in de opleiding, dat je daar op voorhand over moet nadenken en samenwerken, dan denk ik dat technologie het beter kan doen.”

En de huidige wetgeving?

Het hele debat betekent, voor alle duidelijkheid, niet dat u volledig onbeschermd bent op dit moment. “We hebben nu geen regels voor robots, ” legt Hans Graux uit, “maar er bestaan wel al lang regels voor productveiligheid. Denk aan bijvoorbeeld electronica-apparatuur of robotspeelgoed waar je kind tegen kan praten. Dat zijn op zich toestellen die aan specifieke veiligheidsreglementen moeten voldoen.”