Russische onderzoekers hebben met de hulp van artificiële intelligentie een techniek ontwikkeld om een portret te laten bewegen.

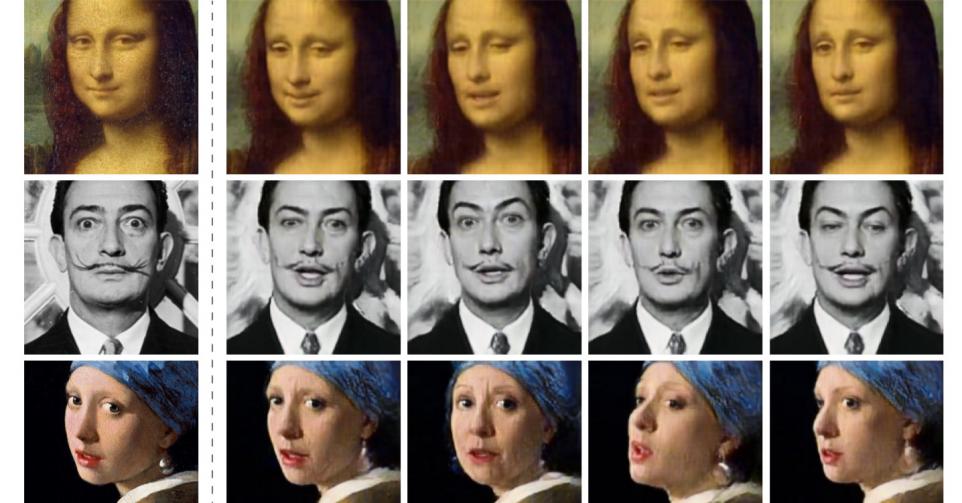

Portretten die plots tot leven komen? Tot nog toe zagen we die enkel in Harry Potter-films verschijnen, maar in de toekomst kan het dagelijkse realiteit worden. Onderzoekers van het Samsung AI-center in Moskou geven alvast een eerste aanzet in een preprint paper die maandag is verschenen op het elektronische platform ArXiv. Het artikel is nog niet gepubliceerd in een wetenschappelijk tijdschrift (en dus nog niet beoordeeld door collega’s), maar de resultaten zien er alvast indrukwekkend uit. In een video doen de Samsung-onderzoekers uit de doeken hoe ze erin geslaagd zijn om de portretten van Salvador Dali, Albert Einstein, Fyodor Dostoyevsky, Marilyn Monroe en zelfs de Mona Lisa aan het praten te krijgen.

Je kan jouw keuzes op elk moment wijzigen door onderaan de site op "Cookie-instellingen" te klikken."

De Russische wetenschappers gebruikten een populaire techniek die bekend staat onder de naam Generative Adversarial Networks. In dit geval werden drie deep learning-netwerken gecombineerd. Eerst leerden ze hun algoritme om expressieve gezichtskenmerken te herkennen, zoals de positie van de ogen, wenkbrauwen, neus, mond en kaaklijn. Daarvoor deden ze beroep op 7.000 bewegende gezichten die ze van een publieke databank haalden. Aan de hand van die voorbeelden werd een eerste neuraal netwerk getraind om de belangrijke punten op het gezicht om te zetten in vectoren die vervolgens naar het ‘generatornetwerk’ gestuurd worden. Dit tweede netwerk tracht om op basis van die vectoren en één nieuwe foto een volledig bewegend gezicht te genereren. Ten slotte evalueert het ‘discriminatornetwerk’ de genereerde video’s en selecteert het de meest realistische.

Het was voorheen al mogelijk om met artificiële intelligentie valse video’s te maken. Nadat iemand een gratis tooltje had gelanceerd waarmee je gezichten in films kunt ‘swappen’, circuleerden vorig jaar de eerste deepfake-video’s op het web. Het duurde niet lang vooraleer pornowebsites video’s moesten verbieden waarin de gezichten van porno-actrices vervangen waren door die van celebrities. Om dergelijke deepfake-video’s te maken is echter veel videomateraal van ‘het slachtoffer’ nodig, terwijl bij deze nieuwe techniek van Samsung één enkele foto al volstaat.

De video’s die op basis van die ene foto gemaakt worden, lijken nog niet perfect. Worden er acht foto’s gebruikt, dan ogen de bewegingen en gezichtsexpressies realistischer. Bij gebruik van 32 foto’s kan je het verschil met een echte video nog amper zien.

De techniek zou gebruikt kunnen worden om bewegende avatars te maken, bijvoorbeeld voor toepassingen in de gaming-industrie. Je zou er ook die ene foto van je overgrootvader mee tot leven kunnen wekken.

Een technologie die op basis van één profielfoto op Facebook al een nepvideo kan maken, zet tegelijk ook de deur open voor misbruik. Recent is binnen de AI-gemeenschap dan ook een debat ontstaan over de vraag of ze dergelijke resultaten wel moeten vrijgegeven.