Software ontwikkeld aan de universiteit van Columbia, kan de patroonherkenningssystemen voor zelfrijdende auto’s automatisch op de proef stellen. Daarmee werden duizenden fouten ontdekt die voorheen nooit opgespoord waren.

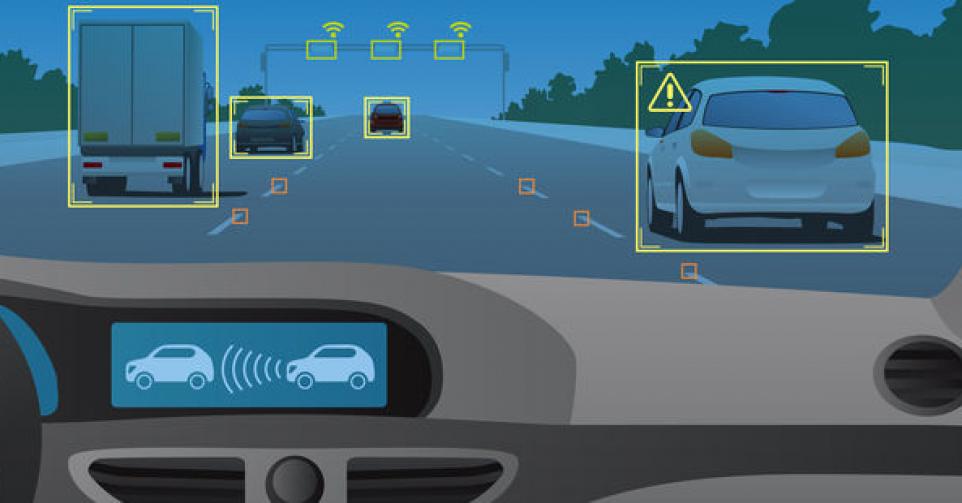

Als we over tien jaar zelfrijdende auto’s de baan willen opsturen, wordt het cruciaal dat we hun systemen voor patroonherkenning altijd en voor de volle honderd procent kunnen vertrouwen. Ze testen op mogelijke fouten is echter niet evident: er is geen code die we zo maar eventjes kunnen gaan ‘debuggen’.

Black box-probleem

Dergelijke systemen gebruiken immers ‘deep learning’ om patronen te extraheren uit grote hoeveelheden data en om bij te leren uit nieuwe input. De oplossing die daaruit komt, blijkt vaak verbluffend goed te werken, maar over hoe die precies tot stand is gekomen, hebben we geen flauw idee. Dat maakt het moeilijk om ze in alle omstandigheden te vertrouwen. Zo kunnen zelfrijdende auto’s beetgenomen worden met gemanipuleerde verkeersborden, waardoor ze de verkeerde beslissing nemen.

Tot nog toe werden die valse foto’s handmatig en doelbewust door mensen gecreëerd om het AI-systeem uit te dagen. Onderzoekers van de universiteit van Columbia hebben nu een manier gevonden om de systemen in zelfrijdende auto’s op een consistente manier te gaan testen: namelijk door de artificiële intelligentie zichzélf op de proef te laten tellen.

Daarvoor ontwikkelden ze DeepXplore. Dat vertrekt van testafbeeldingen waaruit een deep learning-systeem patronen afleidt. Vervolgens gaat het die afbeeldingen geleidelijk manipuleren tot er foute beslissingen gemaakt worden.

Voorspellen wanneer AI uit de bocht gaat

Een voorbeeld. Een AI-systeem krijgt een afbeelding te zien van een weg die een bocht naar links maakt en leert daaruit dat de zelfrijdende auto naar links moet sturen. DeepXplore maakt die afbeelding gestaag donkerder, tot op het moment dat het systeem een tegenstrijdige beslissing genereert. Als het AI-systeem de auto plots vraagt om naar rechts te sturen, dan belandt die in de berm. Dus dan weet het systeem dat het zichzelf in die omstandigheden beter moet trainen, zodat het ook donkere foto’s juist kan interpreteren.

DeepXplore is zo ontworpen dat het de afbeeldingen bewerkt opdat het AI-systeem zo veel mogelijk tegenstrijdige beslissingen maakt. Zo kan het bijvoorbeeld ook het effect van stof op een camera simuleren totdat het AI-systeem in de fout gaat.

Door hun software te testen op vijftien bestaande neurale netwerken, waaronder Nvidia’s Dave 2 netwerk voor zelfrijdende auto’s, ontdekten de onderzoekers duizenden fouten die voorheen nooit opgespoord werden.

DeepXplore kan de deep learning modellen daarna ook gaan hertrainen. Daardoor kan het de nauwkeurigheid ervan met drie procent verhogen, tot 99 procent. Het onderzoeksteam zal die resultaten zondag voorstellen in Shanghai. Haar open-source software heeft ze alvast beschikbaar gemaakt voor onderzoekers die hun eigen AI-systeem willen testen.