Intel heeft een nieuwe AI-chip aangekondigd om te concurreren met Nvidia. Ook Meta werkt aan nieuwe versies van zijn eigen AI-chip.

De nieuwe Gaudi 3 chip van Intel moet large language models zo’n vijftig procent sneller kunnen trainen dan eerdere generaties van H100 processor, zo meldt persagentschap Reuters. Volgens Intel is het ook in staat om sneller antwoorden te berekenen voor generatieve AI, een proces dat ‘inference’ wordt genoemd.

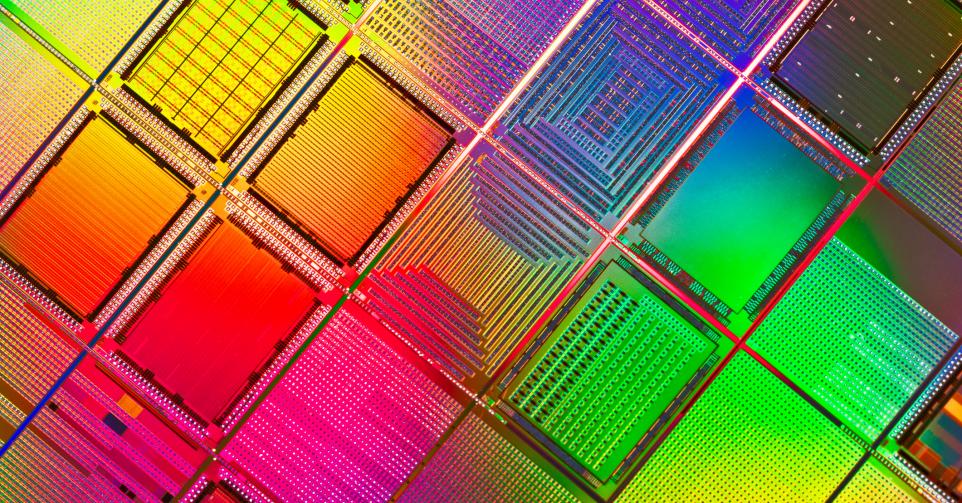

De chips komen er op een moment dat er erg veel vraag is naar chips voor het trainen en draaien van AI-modellen. Nvidia is daar momenteel een van de grootste leveranciers. Het bracht het bedrijf tot een beurswaarde van meer dan twee biljoen dollar. Intel lijkt duidelijk ook een deel van die markt te willen inpalmen.

Artemis

Ook Meta heeft een nieuwe AI-chip aangekondigd. De nieuwe generatie van zijn Meta Training and Inference Accelerator is niet bedoeld voor de bredere markt, maar werd specifiek ontwikkeld om te werken met Meta’s eigen AI-modellen. De chips moeten het trainen van die modellen stevig versnellen.

De eerste versie van MTIA werd vorig jaar aangekondigd. Meta werkt ondertussen dus aan versie 2. Daarmee ‘willen we focussen op de juiste balans tussen compute, geheugenbandbreedte en geheugencapaciteit’, zo schrijft Meta in een blogpost. Ook hier moet veel aandacht gaan naar ‘inference’, het proces dat kunstmatige intelligentie gebruikt om antwoorden te formuleren en conclusies te trekken uit data.

Ieder zijn eigen chip

Meta is alvast niet alleen in het ontwerpen van zijn eigen chips. Eerder kondigde Google al eigen AI-chips aan, ook Microsoft en Amazon bouwen chips die specifiek gemaakt zijn voor hun eigen AI-modellen.

Generatieve AI gaat al een tijd door een stevige evolutie, maar de technologie kwam in een stroomversnelling terecht sinds de introductie van ChatGPT3, vorig jaar. Sindsdien werken steeds meer organisaties en bedrijven aan het trainen van hun eigen AI-modellen. Die training, en het draaien van de modellen zelf, vereist echter een stevige hoeveelheid rekenkracht en data, wat bedrijven noopt tot investeringen in gespecialiseerde chips.