Google haalt antisemitische en vrouwonvriendelijke suggesties uit autocomplete

Nadat uit een artikel van The Guardian bleek dat Google veel antisemitische, seksistische en racistische suggesties deed in autocomplete heeft de zoekgigant dit aangepast.

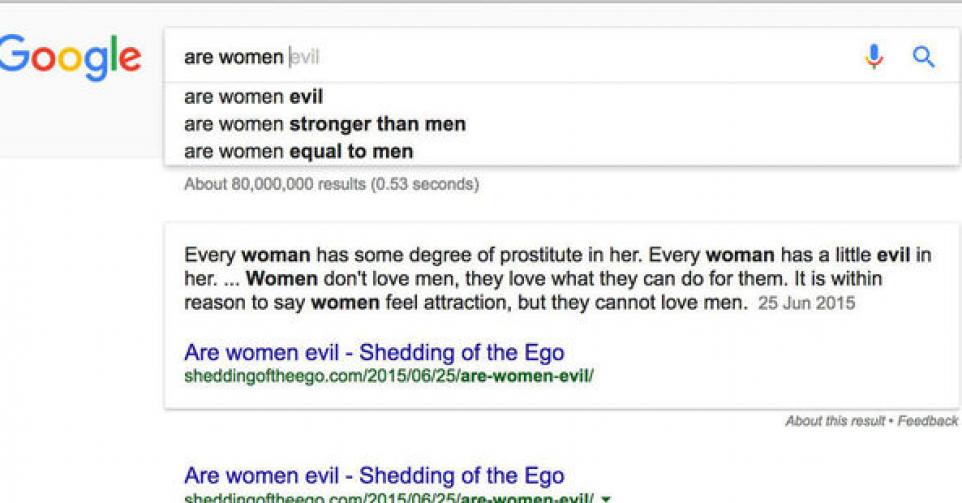

De autocomplete zoekfunctie doet suggesties voor de meest gebruikte zoektermen na een aantal woorden. Na ‘are Jews’ verscheen er vorige week nog ‘evil’, ook na ‘are women’ verscheen ‘evil’ als eerste suggesties en bij ‘are Muslims’ verscheen er ‘bad’.

Gisteren waren die suggesties uit de zoekmachine verdwenen. Een woordvoerder liet aan The Guardian weten dat ze snel actie ondernomen hadden nadat Google hiervan op de hoogte gebracht was. ‘Onze zoekresultaten zijn een reflectie van wat er op het web staat. Dit betekent dat soms onplezierige of gevoelige onderwerpen die online staan invloed kunnen hebben op hoe de resultaten weergegeven worden. Deze reflecteren niet Google’s mening – als bedrijf hechten we veel waarde aan diversiteit van perspectieven, ideeën en culturen.’

Het bedrijf wil voorkomen dat er beledigende suggesties naar voren komen in autocomplete. Ook porno en hatelijke berichten komen niet zomaar naar voren. ‘We erkennen dat autocomplete geen exacte wetenschap is en we werken er altijd aan om het algoritme te verbeteren.’

Niet de eerste keer

Het is niet de eerste keer dat Google met dit probleem te maken krijgt. In juli 2015 was de titel bij een foto van twee donkere tieners op Googles Photos ‘Gorillas’. Een paar maanden eerder moest de zoekgigant nog door het stof, omdat het Witte Huis op Google Maps te vinden was met zoektermen als ‘nigger house’ en ‘nigger king’.

Fout opgemerkt of meer nieuws? Meld het hier