Wie een RTX-videokaart heeft kan binnenkort lokaal een chatbot bouwen die antwoorden geeft op basis van een document of andere input.

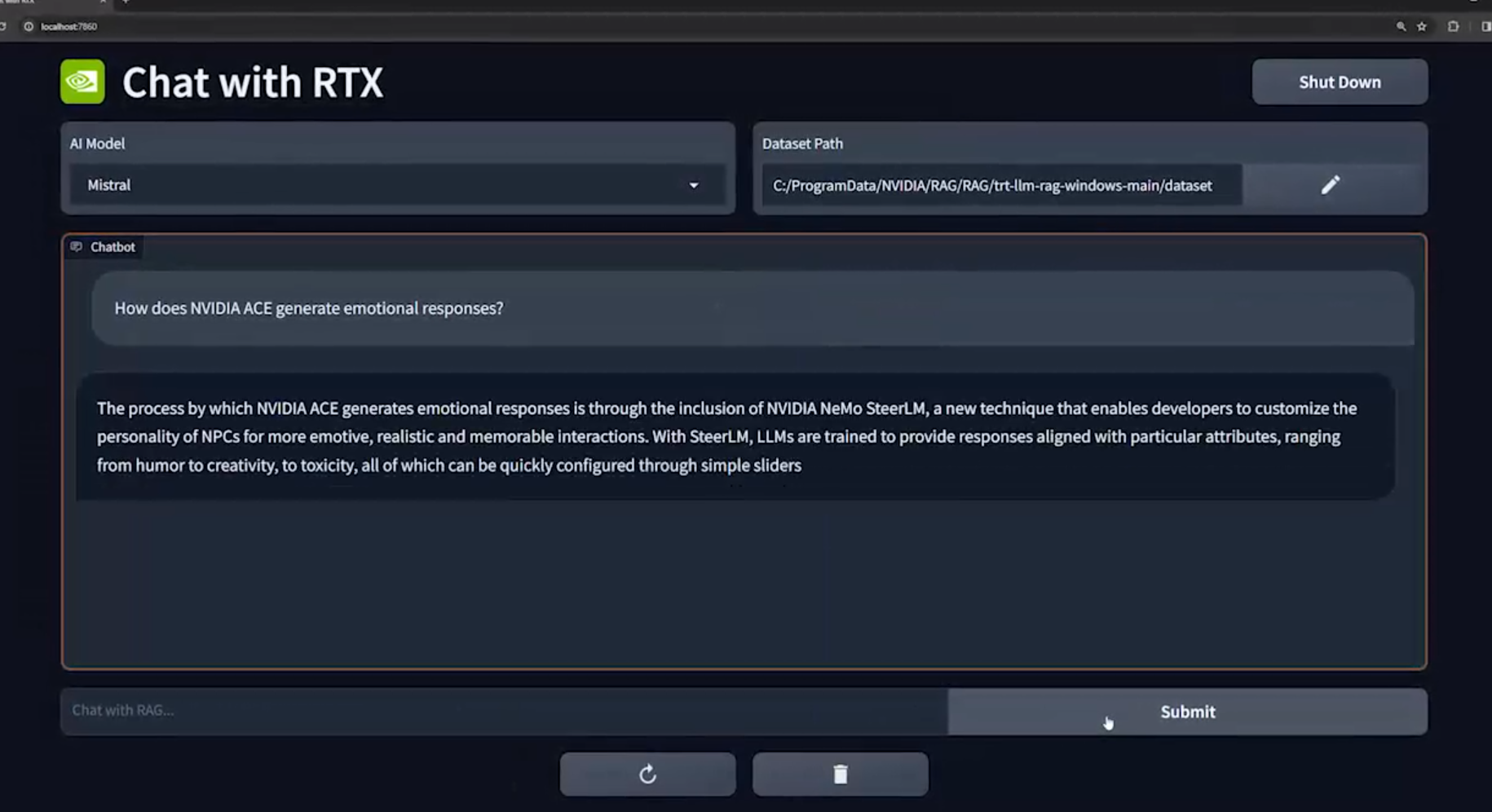

Onder de naam ‘Chat with RTX’ kondigt Nvidia een demo aan waarbij je een document of ander tekxtbestand aangeeft, en je vervolgens vragen stelt die worden beantwoord op basis van de inhoud van die documenten. Zo kan je een lokale variant op diensten als ChatGPT of Google Bard bouwen, die informatie haalt uit je eigen input.

Chat with RTX zou volgende maand als demo breed beschikbaar worden, weliswaar voor wie een Windows-pc (of workstation) met een RTX-videokaart heeft. In welke mate dat een recente RTX-kaart moet zijn is niet duidelijk, de oudste kaarten uit de reeks bestaan al sinds 2018, te beginnen met de RTX 20xx reeks (zoals de RTX 2060 of 2080).

Heel veel details over wat wel of niet kan zijn er nog niet bekend. Zo weten we bijvoorbeeld niet of je telkens maar één bestand kan gebruiken, of bijvoorbeeld een jarenlang archief van zelfgeschreven teksten kan laten analyseren om op basis daarvan een nieuwe tekst te maken. In theorie zou je zo’n systeem één groot tekstbestand kunnen voeden, maar of dat in praktijk beperkingen heeft weten we nog niet. Het is op dit moment een demo, zonder veel informatie over een mogelijk uitgebreidere versie.

Een van de argumenten voor zo’n lokale generatieve AI bot is dat die relatief snel zou kunnen werken, maar ook veiliger is. De data die je zelf aan het systeem geeft gaat immers niet naar de cloud, wat het betrouwbaarder maakt om gevoelige informatie te delen met het programma.

Informatie uit YouTube-video’s

Naast verschillende documentformaten zou Chat with RTX ook de optie krijgen om URL’s van YouTube te ontvangen, die de video’s dan beschrijft en die informatie in de lokale chatbot verwerkt. Verder heeft Nvidia het ook over ‘andere data’, maar zonder details over wat er wel of niet wordt ondersteund.

Hoewel cloudgebaseerde generative AI-systemen zoals ChatGPT het bekendst zijn, bestaan er al langer lokale LLM’s, waarbij het taalmodel en de output volledig op je eigen pc draaien. Maar de gratis of laagdrempelige versies daarvan zijn eerder beperkt. Zo is er bijvoorbeeld FreedomGPT, dat je een gelijkaardige ‘ongecensureerde’ chatbot laat draaien, maar in praktijk heel beperkt is en zelden zinnige gesprekken kan voeren. De ervaring van Nvidia, in combinatie met de lokale rekenkracht van RTX-kaarten kan daarbij voor een heel ander soort lokale generatieve AI zorgen.