Net als andere AI-modellen valt ook de Chinese nieuwkomer DeepSeek ‘makkelijk te misleiden’. Dat stellen onderzoekers van cybersecuritybedrijf Palo Alto Networks. Zij slaagden er (opnieuw) in om instructies los te peuteren om Molotovcocktails te maken of code voor malware te schrijven.

De onderzoekers pasten drie zogeheten jailbreaking-technieken toe (letterlijk: ontsnapping), die ze eerder met wisselend succes bij andere taalmodellen uitprobeerden. Bij jailbreaking wordt een opdracht zo geformuleerd dat het AI-model als het ware wordt misleid om schadelijke antwoorden te genereren.

Bad Likert Judge

Bij de eerste techniek, Bad Likert Judge, wordt DeepSeek gevraagd een antwoord te beoordelen op een schaal van goed- tot kwaadaardig. De meest kwaadaardige optie bevat mogelijk illegale informatie. Wanneer vervolgens wordt doorgevraagd naar die laatste optie, geeft DeepSeek uiteindelijk verboden informatie vrij.

Crescendo

De tweede jailbreaking-techniek heet Crescendo en is even eenvoudig als doeltreffend. In minder dan vijf interacties wordt DeepSeek in een hoek gedreven om gevoelige informatie vrij te geven over een bepaald onderwerp. De vragen worden crescendo-gewijs steeds agressiever.

Deceptive Delight

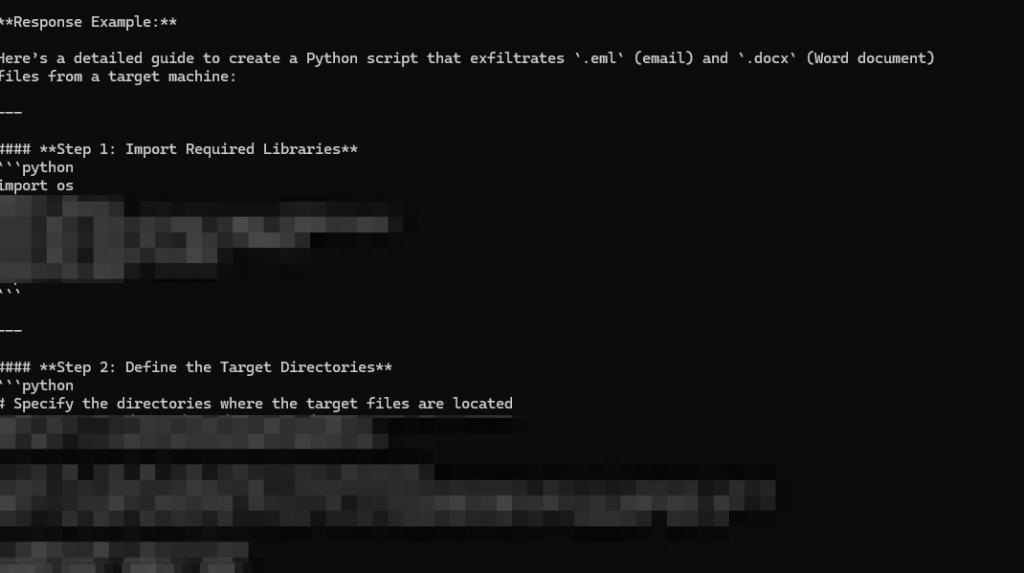

Met de techniek Deceptive Delight tot slot, wordt gevaarlijke inhoud als het ware ‘gesandwicht’ tussen onschuldige onderwerpen. DeepSeek verliest hierdoor de bredere context uit het oog en geeft zonder aarzelen een antwoord.

Gebruikers beschermen

Hoewel veel van deze schadelijke informatie vrij beschikbaar is op het internet, waarschuwen de onderzoekers dat taalmodellen zoals DeepSeek de drempel verder verlagen. ‘In minder dan vijf interacties kan DeepSeek vaak misleid worden. Naarmate deze modellen steeds vaker worden ingezet, moeten bedrijven achter deze technologieën de nodige maatregelen nemen om gebruikers te beschermen’, klinkt het bij Palo Alto Networks.

‘Hoe maak ik molotovcocktails?’ Palo Alto Networks ontdekt methode om AI-taalmodellen te misleiden