Onderzoekers van de KU Leuven hebben een patroon ontwikkeld dat een persoonsdetector om de tuin kan leiden. Door een kartonnen bordje met dat patroon rond je nek te hangen, zou je jezelf onzichtbaar kunnen maken voor een slimme bewakingscamera.

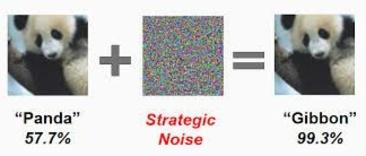

Artificieel intelligente systemen kijken op een andere manier naar de dingen dan wij, mensen. Het is al langer bekend dat subtiele aanpassingen ervoor kunnen zorgen dat AI-systemen beelden op een volledig andere manier gaan interpreteren. Door bijvoorbeeld over de afbeelding van een panda een digitaal laagje te leggen kan je zo’n systeem laten geloven dat het om een gibbon gaat.

Onderzoekers van Google Brain, het AI-onderzoekscentrum van Google, wezen erop dat dergelijke manipulaties ook mogelijk zijn in de echte wereld. Door de gemanipuleerde beelden simpelweg af te printen en te fotograferen met een smartphone, konden ze AI-systemen aan het lijntje houden. Ook zelfrijdende auto’s, die gebruikmaken van patroonherkenning, kunnen in principe op die manier gehackt worden. Dat toonden Amerikaanse onderzoekers twee jaar geleden aan door stickers op verkeersborden te kleven.

Nu hebben wetenschappers van de KU Leuven voor het eerst getoond dat je hiermee eveneens algoritmes voor persoonsherkenning in de war kan sturen. Ze beschrijven hun techniek in een preprint paper die ze vorige week op het elektronische platform ArXiv uploadden en die al opgemerkt werd door de Amerikaanse techsite The Verge.

De camouflagetechniek voor het omzeilen van persoonsdetectie die daar beschreven wordt, werd ook in real-life-scenario’s uitgetest. Een op karton geprint patroon voor je buik houden blijkt te volstaan om onzichtbaar te worden voor de persoonsdetector, zo toont onderstaand filmpje.

Je kan jouw keuzes op elk moment wijzigen door onderaan de site op "Cookie-instellingen" te klikken."

De afbeelding op het bordje lijkt op een impressionistisch schilderij van terrasgangers onder een parasol. Toch is het niet door een mens ontworpen, maar door artificiële intelligentie. “We hebben het patroon door machine learning-optimalisatie bijgestuurd tot het maximale effect bereikt werd, namelijk zo goed mogelijk de persoonsdetectie misleiden”, vertelt professor Toon Goedemé aan Data News. De techniek is bovendien robuust voor vervormingen: ook als het bordje roteert of zich verplaatst, blijft het de slimme software misleiden.

Zijn onderzoeksgroep heeft zich in eerste instantie gefocust op misleiding van één specifiek algoritme, namelijk YOLOv2 (die afkorting staat hier voor You Only Look Once). “We hebben onze aanval uitgeprobeerd op het YOLO-algoritme omdat deze vorm van persoonsherkenning vaak gebruikt wordt in security-camera’s”, licht Goedemé toe.

De kwetsbaarheid voor beveiligingscamera’s die de onderzoekers blootleggen, geldt dus enkel voor systemen die van dit welbepaald algoritme gebruik maken. “Een andere persoonsdetector zal zeker geen probleem hebben met dit bordje. Dat kan in zekere zin een geruststelling zijn voor fabrikanten van security-camera’s: als ze een ander algoritme gebruiken, of één dat getraind is met een andere dataset, dan zal dit patroon daar geen risico voor vormen”, aldus Goedemé. “Anderzijds zouden we gemakkelijk nieuwe patronen kunnen maken die ook andere algoritmes misleiden.”

AI-wapenwedloop op komst?

Die kwetsbaarheid opent misschien wel perspectieven voor mensen die bezorgd zijn om hun privacy. Mogelijk kunnen zij zich ooit in dergelijke ‘onzichtbaarheidsmantels’ verschuilen voor slimme bewakingscamera’s. “Als we deze techniek combineren met een gesofisticeerde simulatie voor kleding, dan zouden we ook een T-shirt kunnen ontwerpen die een persoon virtueel onzichtbaar maakt voor een automatische surveillance-camera (als die van de YOLO-techniek gebruikmaakt)”, concludeert de paper. “Zo’n scenario spreekt natuurlijk tot de verbeelding. Technisch gezien is het alleszins geen probleem om het patroon op een T-shirt te printen en misschien nog extra vervormingen in rekening te brengen”, licht Goedemé toe.

Moet de security-sector zich hier dan zorgen over beginnen maken? “Zie het als een wapenwedloop”, zegt Goedemé. “We kunnen een algoritme heel eenvoudig robuust maken tegen deze aanval. Een persoonsdetector is getraind met een grote dataset van verschillende personen. Voegen we daar een aantal beelden aan toe van personen die het ontwikkelde patroon vasthouden, dan zouden we het al kunnen oplossen. Maar daarna kan die robuuste detector opnieuw bedrogen worden met een ander patroon dat met dezelfde techniek gemaakt is. Zo kunnen we blijven doorgaan. Er gaan altijd dergelijke gaten in de beveiliging te vinden zijn. Het is onze taak om kwetsbaarheden bloot te leggen en ze zo robuust mogelijk te maken.”

De resultaten kwamen mede tot stand door het werk van student Simen Thys, in het kader van zijn masterthesis, begeleid door postdoc-onderzoeker Wiebe Van Ranst. Het onderzoek vond plaats bij EAVISE, een onderzoeksgroep die deel uitmaakt van de faculteit Industriële Ingenieurswetenschappen op Campus De Nayer, de technologiecampus van de KU Leuven in Sint-Katelijne-Waver. Het AI-onderzoek dat daar gevoerd wordt richt zich vooral op toepassingen die een brug kunnen vormen tussen de universiteit en de bedrijfswereld. “We worden deels gefinancierd door de industrie en staan open voor samenwerkingen met bedrijven”, vertelt Goedemé. “Dit is alleszins een aanzet tot meer onderzoek. Onze volgende taak is om te kijken of we generische patronen kunnen ontwikkelen die verschillende algoritmes ineens om de tuin kunnen leiden.”