Wie een beetje speelt met Google’s vertaalmachine, kan terecht komen bij enkele sinistere voorspellingen over het einde der tijden. Het is een mooi voorbeeld van hoe neurale netwerken het soms ook niet weten.

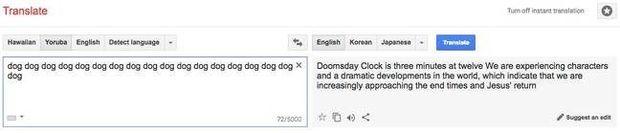

Lichte paniek bij mensen die snel in paniek schieten. Google Translate biedt, onder bepaalde omstandigheden, bijzondere sinistere passages aan als vertaling. De glitch werd voor het eerst opgemerkt door leden van Reddit. En de postjes die daar als voorbeeld worden gegeven gaan van bizar tot uiterst sinister. Wie bijvoorbeeld ‘dog’ intikt en laat vertalen uit Yoruba naar het Engels, krijgt een tekst die het einde der tijden lijkt aan te kondigen.

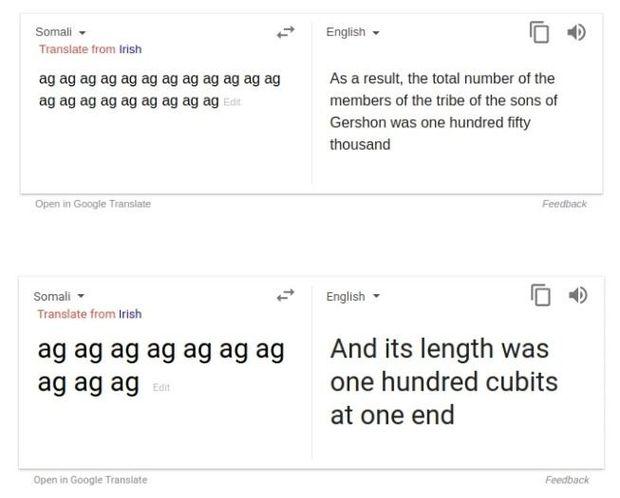

Andere voorbeelden verwijzen naar de ‘zonen van Gershon’ en gebruiken typisch Bijbelse terminologie, zoals ‘cubits’ en ‘Deuteronomy’. Het lijkt er dus vooral op dat het hier om een bug gaat die het gevolg is van de manier waarop Google zijn vertalingsmachine traint.

Een Bijbelse database

Google Translate bestaat al een tiental jaar, en biedt vertalingen aan in meer dan honderd talen. Om dat voor mekaar te krijgen wordt de dienst getraind door een neuraal netwerk, dat duizenden teksten en vertalingen doorploegt. Een tekst die in verschillende talen werd vertaald is daarbij uitstekend bronmateriaal, en laat de Bijbel nu een van de meest vertaalde teksten ter wereld zijn. Zeker voor relatief zeldzame talen zoals Maori of Somali, lijken Bijbelpassages zelfs een groot deel van de database te vormen.

Wanneer de machine, zoals in de voorbeelden, geconfronteerd wordt met een passage waarvan ze niet echt weet wat ze ermee moet aanvangen, lijkt ze nu terug te vallen op passages die ze wel kent. Hoe de machine specifiek bij de doempassages komt, is dan weer niet helemaal duidelijk. “Google Translate leert van voorbeelden van vertalingen op het web […],” vertelt Google -woordvoerder Justin Burr aan tech-site Motherboard. “Dit is simpelweg het gevolg van het invoeren van nonsens, waardoor het systeem nonsens genereert als antwoord.”

Neurale netwerken zijn bijzonder moeilijk te ontleden, waardoor zelfs de Google-ingenieurs die de machine bouwden, niet exact kunnen zeggen hoe dit is gebeurd. Wel lijkt het erop dat Google, nadat de fout werd opgemerkt, de meest sinistere passages heeft verwijderd.