Met een stukje eigen middleware als ‘geheime saus’ wil controller-fabrikant Phison GPU’s efficiënter benutten. ‘AI-training is dan niet langer voor de ‘happy few’, klinkt het.

De roep om artificiële intelligentie op de eigen bedrijfsinfrastructuur klinkt steeds luider. Zeker ook in Europa: gedreven door de noodzaak om gevoelige data binnen de bedrijfsmuren en soeverein te houden. Maar de realiteit oogt anders. Denk aan torenhoge kosten voor GPU’s die dan ook nog eens beperkt beschikbaar zijn. De gespecialiseerde Taiwanese controller-fabrikant Phison schuift met aiDAPTIV+ een pragmatische oplossing naar voor. Door betaalbare flash-opslag in te zetten als een extensie van het dure VRAM, wordt het trainen van grote taalmodellen plotseling haalbaar voor een veel breder publiek. ‘AI-training is dan niet langer weggelegd voor alleen maar de ‘happy few’’, vertelt Michael Wu, general manager & president van Phison Technology Inc. (USA) tijdens een bezoek van de IT Press Tour in Californië waarop Data News ook aanwezig was.

‘Door de AI- en geheugenmuur breken’

Innovatie zit soms in een klein hoekje. Maar de disruptie kan groot zijn. Dat is zowat het effect waar Phison op hoopt. In dit geval: om door de AI and Memory Wall te breken, zoals Brian Cox van Phison het ons uitlegt: ‘De complexiteit en omvang van AI-modellen groeit, uitgedrukt in parameters, met een factor 410 om de twee jaar. De capaciteit van het extreem snelle, maar peperdure High Bandwidth Memory (HBM) of GDDR-geheugen (Graphics Double Data Rate, een specifiek uiterst performant geheugen, nvdr) op professionele GPU’s, evolueert in diezelfde periode slechts met een factor twee’, vertelt Cox.

Dit dwingt bedrijven nu vaak tot dure noodoplossingen. ‘Ik heb klanten gesproken die meerdere GPU-kaarten moesten kopen, niet omdat ze de extra rekenkracht nodig hadden, maar puur voor de geheugencapaciteit die op die kaarten zat’, zegt Cox. ‘Een groot deel van de GPU’s bleef ongebruikt.’

Ontwikkeld vanuit eigen noodzaak

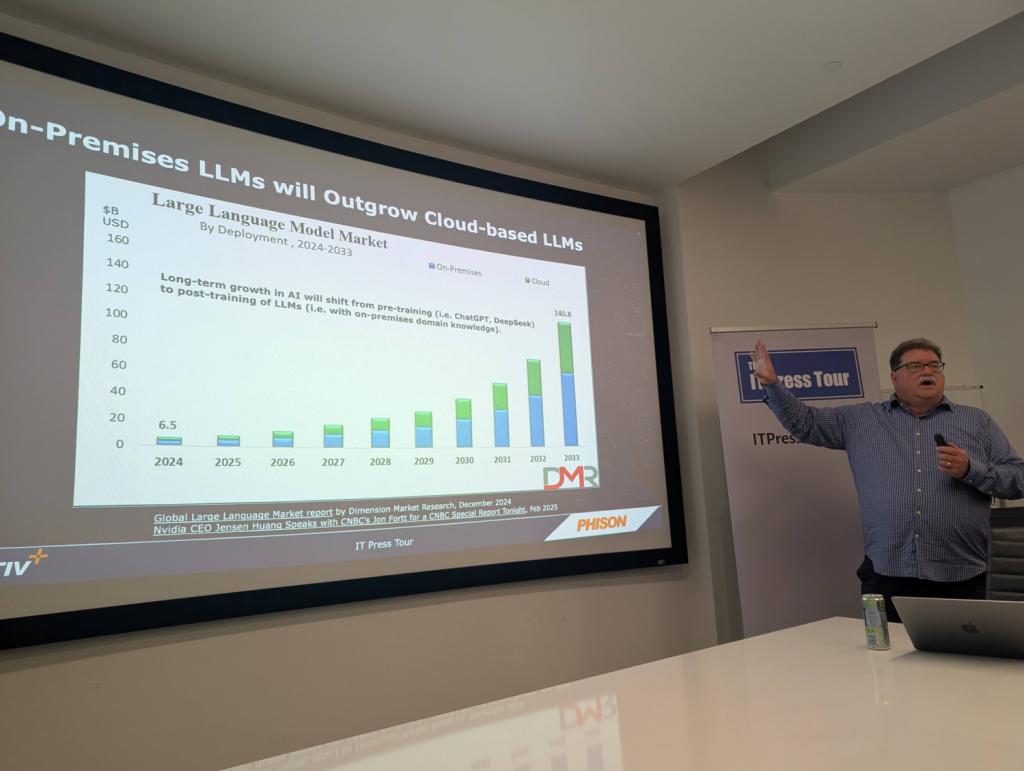

Deze uitdaging wordt des te prangender naarmate on-premise AI-toepassingen die van de publieke cloud-modellen op termijn zullen overstijgen. Dat is toch waar Phison vanuit gaat, op basis van een analyse van marktonderzoeker Dimension Market Research.

Maar de rechtstreekse aanleiding waarom Phison een oplossing hiervoor ontwikkelde? Dat was in eerste instantie uit eigen noodzaak, zo blijkt. ‘Onze CEO, K.S. Pua, wilde AI toepassen om onze eigen ontwerp- en productieprocessen te verbeteren, maar de prijs die men hem voorstelde was enkele miljoenen dollars’, zegt Cox. ‘Het antwoord van onze CEO was duidelijk: ‘Dat kan ik me niet veroorloven. Zoek een efficiëntere manier’. Dus dat hebben we gedaan’, lacht Brian Cox.

SSD als redder in nood

Die efficiëntere manier luistert dus naar de naam aiDAPTIV+. Het concept is even eenvoudig als doeltreffend: in plaats van een volledig AI-model in het beperkte en dure VRAM van de GPU te laden, wordt het model op een veel grotere en goedkopere NAND flash-opslagmodule geplaatst. De ‘geheime saus’ is de aiDAPTIVLink middleware, een stuk software dat functioneert als een intelligente verkeersregelaar. Deze software laadt de nodige ‘schijfjes’ van het model van de SSD naar de GPU, precies wanneer die ze nodig heeft voor de verwerking, en zorgt ervoor dat de GPU-pipeline constant gevoed blijft. De hardwarecomponent, aiDAPTIVCache genaamd, is geen standaard SSD. Omdat het trainen van AI-modellen een enorm schrijfintensief proces is, ontwikkelde Phison een gespecialiseerde drive die tot 100 ‘Drive Writes Per Day’ (DWPD) aankan. Daarvan moet je vooral onthouden dat dit ver boven de norm voor zelfs de meest robuuste enterprise SSD’s ligt.

Afwegen van tijd en geld

Phison is wel realistisch: ‘Het is een technologische afweging. Sorry, we’re trading cost’, gaf Cox toe tijdens de presentatie. De training van een model duurt langer dan wanneer men een ongelimiteerd budget heeft voor een serverfarm vol met de duurste GPU’s. Een illustratie uit Phisons eigen lab toont aan dat het trainen van een 70B-parametermodel op een werkstation met vier GPU’s zonder aiDAPTIV+ simpelweg mislukt door een gebrek aan geheugen. Met aiDAPTIV+ lukt het wel, in iets meer dan vier uur. ‘Maar je kan wel op start drukken, gaan lunchen, en tegen dat je terugkomt is het klaar’, stelt Cox: ‘Voor veel middelgrote ondernemingen, universiteiten of R&D-afdelingen die niet elk uur, maar misschien dagelijks of wekelijks bepaalde modellen moeten hertrainen, is dit een meer dan aanvaardbaar compromis. De beloofde kostenbesparing van een factor 8 tot 10 is dan de doorslaggevende factor’, besluit hij.

‘Onze SSD’s zitten zelfs in een datacenter op de maan’

De aiDAPTIV+ innovatie komt niet uit het niets. Het is het resultaat van een bewuste strategie van Phison om te transformeren van een toch vooral anonieme controller-leverancier voor de consumentenmarkt naar een volwaardige enterprise storage-partner. Het bedrijf ontwerpt en bezit de intellectuele eigendom van zowel de controller, de firmware als de hardware en kan ook diepgaand maatwerk leveren. Het meest extreme voorbeeld daarvan is de samenwerking met Lonestar, waarvoor Phison een SSD op maat ontwikkelde die de straling en temperatuurschommelingen op de maan kan doorstaan. Ook in het internationaal ruimtestation ISS en zelfs op Mars zijn al SSD’s van Phison te vinden. Het bedrijf brengt de enterprise SSD’s trouwens onder de merknaam Pascari op de markt.

Data-opslag op Mars (en binnenkort ook de maan)